人在美国,待过三家AI Lab,全凉了!

人在美国,待过三家AI Lab,全凉了!科技行业全球10万大裁员,连10年老将田渊栋都被Meta裁掉了!昨天,南洋理工大学的副教授Boyang Li吊足了大家的胃口:Meta FAIR最近的事件很抓马,但工业研究为什么这么难?我想知道大家愿不愿意听一下我的观点。

科技行业全球10万大裁员,连10年老将田渊栋都被Meta裁掉了!昨天,南洋理工大学的副教授Boyang Li吊足了大家的胃口:Meta FAIR最近的事件很抓马,但工业研究为什么这么难?我想知道大家愿不愿意听一下我的观点。

在最近一篇来自Meta FAIR团队的论文里,研究者找到了一种前所未有的方式——他们能实时看到AI的思考过程。这项名为CRV的方法,通过替换模型内部的MLP模块,让每一步推理都变得「可见」。这不是隐喻,而是可量化的现象。Meta用它让错误检测精度提升到92.47%,也让人类第一次得以窥见AI是怎么想错的。

早在 2021 年,研究人员就已经发现了深度神经网络常常表现出一种令人困惑的现象,模型在早期训练阶段对训练数据的记忆能力较弱,但随着持续训练,在某一个时间点,会突然从记忆转向强泛化。

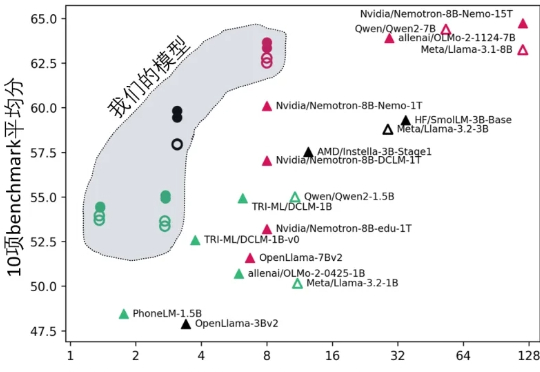

刚刚,Meta FAIR推出了代码世界模型!CWM(Code World Model),一个参数量为32B、上下文大小达131k token的密集语言模型,专为代码生成和推理打造的研究模型。这是全球首个将世界模型系统性引入代码生成的语言模型。

加拿大AI新贵Cohere获5亿美元融资、估值68亿美元,前Meta FAIR副总裁、PyTorch与Llama重要推手Joelle Pineau加盟出任首席AI官,或将开启企业AI新战局。

《Physics of Language Models(语言模型物理学)》,正是将AI研究带入“物理学范式”的项目,由Meta FAIR研究院的朱泽园概念化发起,并统筹设计。

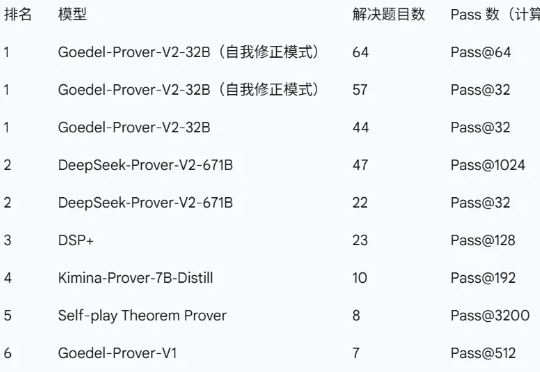

近日,由普林斯顿大学牵头,联合清华大学、北京大学、上海交通大学、斯坦福大学,以及英伟达、亚马逊、Meta FAIR 等多家顶尖机构的研究者共同推出了新一代开源数学定理证明模型——Goedel-Prover-V2。

图灵奖大佬向97年小孩哥汇报,这是什么魔幻剧情?小扎砸143亿请来的「数据标注少年」,已荣升Meta首席AI官。一边是小扎上亿美元年薪offer引进新员工,另一边是Meta老将GPU告急不得不熬夜借卡差点头秃。网友们痛呼:太为Meta FAIR的员工难过了……

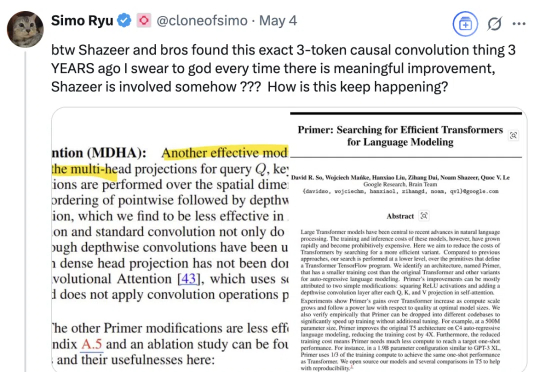

怎么老是你???(How old are you)尤其是最近Meta FAIR研究员朱泽园分享了他们《Physics of Language Models》项目的系列新进展后,有网友发现,其中提到的3-token因果卷积相关内容,沙哥等又早在三年前就有相关研究。这是最近网友不断对着Transformer八子之一的Noam Shazeer(为方便阅读,我们称他为沙哥)发出的灵魂疑问。

Meta FAIR新负责人上任,联合创始人回归: